In der Kuchl ![]()

Edit: Die Kuchl ist wohl dahinter, dann wohl Esszimmer.

In der Kuchl ![]()

Edit: Die Kuchl ist wohl dahinter, dann wohl Esszimmer.

Finde ich jetzt nicht so dramatisch. Dauert die Installation so halt etwas länger und ist ja nur für die Ersteinrichtung.

Danach installiert man unter XP die USB 3.0 Treiber und dafür habe ich zB eine 128GB micro SDXC Karte eingerichtet (externer 3.0 Cardreader, weil der integrierte nur USB 2.0 unterstützt) für diverse Spiele aus der XP Ära.

Die 64GB Kingston SSD vom Vorbesitzer ist flott genug für XP und hat erst 2300 Betriebsstunden drauf.

Bei meinem Foxconn NT-A3800 das gleiche, 2x USB 3.0 (ASMedia Controller) vorne und 4x USB 2.0 (wohl in Southbridge integriert) hinten. Booten geht nur mit dem 2.0er. Windows XP habe ich einfach über ein externes USB 2.0 DVD-RW Laufwerk (LG) installiert, welches ich anno ~2010 gekauft haben müsste.

Der Thermaltake Golden Orb TK7FR01 sieht optisch gut aus, aber das wars dann aber dann auch schon. Der Alpha und beide Global WIN bleiben bei diesem Test die Sieger in Sachen Kühlleistung: https://www.hwupgrade.it/articoli/cpu/1…i-slot-a_6.html

Ich habe eine Cobra ![]() Soundkarte hier, die YAMAHA AW744L II PCI von AOpen. New old stock...

Soundkarte hier, die YAMAHA AW744L II PCI von AOpen. New old stock...

Dein Erfahrungsbericht reizt mich auch sie dann ins Slot A Sy einzubauen, wo derzeit eine Vortex 2 drin werkelt.

Im PIII Slot 1 Sys habe ich eh schon eine Vortex 2 von Diamond drin, darum wäre das eigentlich kein Problem.

Aslinger Du musst mal unbedingt Giants auf der MAXX spielen. Das Spiel sieht so genial schön aus auf ATis Rage.

Giants habe ich mit dem speziellen DirectX 8 Patch für Bump Mapping Support (ab GeForce 3) auf der GeForce 4 Ti gezockt, dann sollte es am schönsten aussehen, alternativ auch sonst auf einer Radeon 8500: https://www.giantswd.org/?file=12

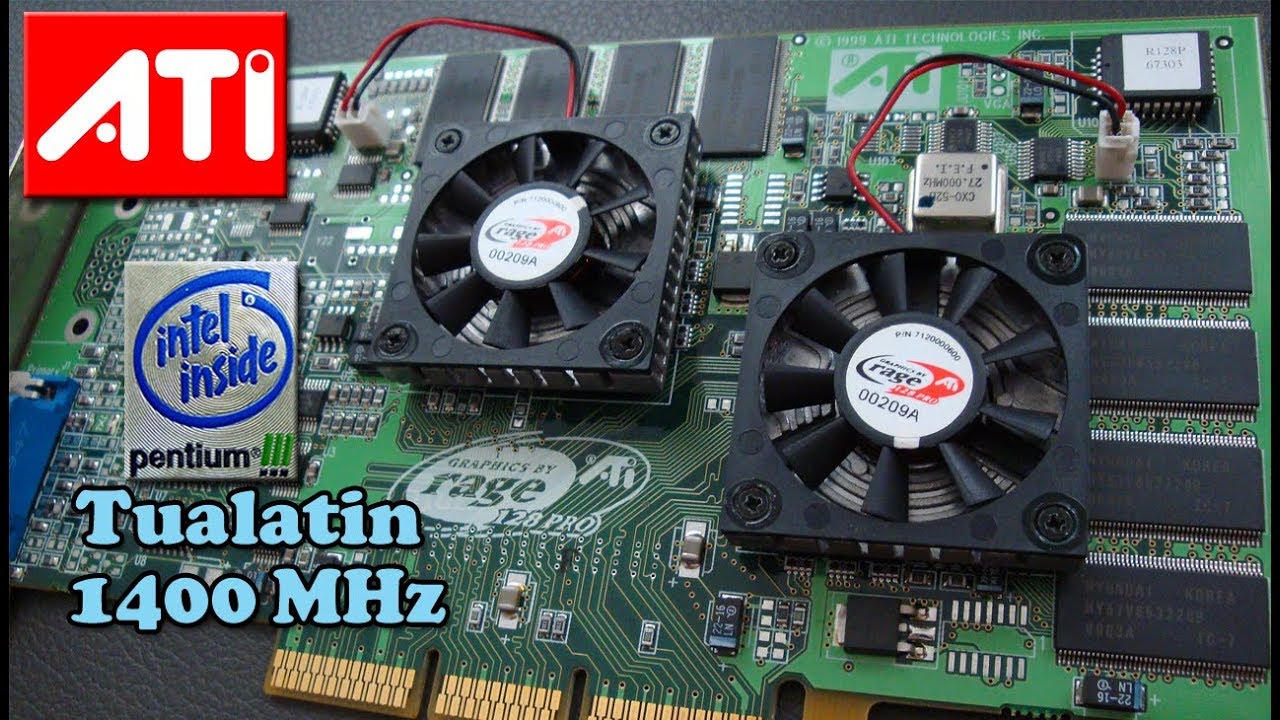

Ich habe die MAXX nur auf einem Asus TUSL2C mit i815EP erfolgreich getestet, hier ist auch ein mittlerweile altes Beweisvideo (der Tualatin 1400er ist natürlich etwas Overkill):

MDK2 zB, ein OpenGL Spiel, läuft ohne Mikroruckler, (Vsync off) während Quake 3 nur mit einem Chip ein stressfreies Spielen für die Augen zulässt. Dieses typische Mikroruckeln in OpenGL Spielen tritt wohl nicht überall auf. Habe ich leider nie richtig ausgetestet, ob das Mikroruckeln im Dual Chip Modus nur bei der Quake Engine auftritt...

Ja, es ist eine Creme de la Creme Karte, vor allem unter Direct3D mit 32Bit Farben und würde sicher auch gut in mein Slot A 1GHz Athlon Sys passen, wo derzeit eine Voodoo4 AGP drin werkelt. ![]()

HIER hat jemand das AK72 mit einer MAXX am laufen, würde nur das letzte Bios flashen.

Bei der Voodoo2 würde ich die letzten FastVoodoo2 4.6 für 98/ME nutzen, die haben auch den Athlon Fix drin. Selbst habe ich aber nie V2 SLI mit AMD benutzt.

Der i440 BX soll wohl das flotteste für V2 SLI sein, wegen der sehr guten PCI Performance. Beim VIA würde ich einfach gucken, dass alle PCI Performance kritischen Einstellunen wie zB PCI Master Read Caching, PCI Dynamic Burstng oder CPU to PCI Write Buffer im Bios aktiviert ist.

Hier ist ein Tuningsguide für den KX133: https://www.au-ja.de/review-kx133-tuning.phtml

Mit einem 512MB Infineon 133MHz CL2/2/2 läuft mein Asus K7V-T (gleicher Chipsatz wie das AOpen AK72) völlig stabil mit asynchronen 133MHz. VIO Voltage auf 3,3V runter gestellt.

Steht drin, dass man die 100MHz Baseclk nicht verändern kann. Mir gehts nur um die Spannungen von CPU und NB, damit vor allem der Quirl nicht mehr so nervtötend hoch dreht.

Kann ich hier nicht bestätigen. CPU-Z, als auch AIDA64 meldet alles korrekt und die CPU Temp der beiden Kerne ändert sich auch sofort, während ich bei einem Prime 95 Lauf mit der Spannung herum spiele.

Unter 30 Min. Prime 95 Lauf mit 1.225V, bei 1.37V Stock mind. 5° mehr, nicht dramatisch, aber immerhin:

Meinen gebrauchten Foxconn nT-A3800 AMD E2-1800 mit 4GB Single Channel DDR3 1333, Radeon HD7340, und einer 60GB Kingston V300 kam auch gestern an. Heute zerlegt, alles gereinigt, die WLP getauscht (die originale war extrem vertrocknet). Der kleine Quirl Lüfter nervt halt etwas, da werde ich mir bei Zeiten noch was einfallen lassen.

XP SP3 32Bit läuft soweit drauf im IDE Modus, Treiber konnte ich alle manuell auftreiben (Card Reader, LAN, WLAN, USB3, Chipsatztreiber und AMD Grafiktreiber).

Mafia und 3DMark 01/03 habe ich kurz angetestet und ich fand auch ein Tool, damit ich CPU und Northbridge undervolten kann, und für ein manuelles Cool&Quiet. Das Tool nennt sich Brazos Tweaker (ich habe ja eine Brazos APU, kA ob das auch mit anderen kompatibel ist):

Die 40nm CPU taktet standardmäßig mit 1,7Ghz und 1,375V im P0 Statee. Ein kurzer Test erlaubte auch 1,25V (30 Min. Prime). Muss ich aber noch alles ausgiebig testen. Northbridge Spannung standardmäßig auf 0,90V. 0,85V angetestet.

Für 10€ Kaufpreis top und muss nichts investiert werden.

Das K7S6A ist allerdings schon wieder zu neu für mich, das interessiert mich im Sockel A Bereich schon nicht mehr. Genau so wie nForce 2 und der ganze neumodische Krempel

Ach, bis zur S1366 Plattform (X58) gehe ich auch noch mit, das war auch die letzte Plattform inkl. der Mainstreamversion P55, wo man den BCLK noch frei hoch heben konnte, auch bei Intel Xeon CPUs, das war ja bei Intel ab 2011 mit dem X79/P67 vorbei und man benötigte eine Extreme Version um wenigstens den Multi anheben zu können, darum nutze ich auch heute noch immer mein X58 Sys, was mittlerweile schon zu den Youngtimern gehört. X58/P55 war auch die letzte Gen. mit klassischem Bios.

Neumodische PCs habe ich nur einen HP AMD Ryzen 3700U Lapi aus 2019, war auch das letzt gekaufte neumodische Computer Zeugs. Der hat nicht mal mehr eine CMOS Batterie, sondern der fix eingebaute Akku hält da die CMOS Einstellungen bei und die CPU ist auf dem Mainboard verlötet. Er läuft soweit, aber ich kaufe in Zukunft nur mehr noch älteres gebrauchtes nicht Wegwerf Notebooks.

soggi Auch bei Autos interessiert mich nur alles bis zu den frühen 2000ern, und bei Technik keine Soundbar und SMART Gedöhns, kein E-Bike...

AMD Opteron 180/185 Dual-Core, Socket 939 (nForce 3/4) System. Das wäre mein Favorit, wenn der Stromverbrauch egal ist und was nicht so gängiges für XP. Beim nForce3 AGP Unterbau muss halt eine Radeon 3850/4670 her, das schnellste für AGP.

Nein, aber einen Vergleichstest 166 vs 200 MHz, da ist aber kein NOLF dabei.

NOLF1 ist gut spielbar auf einer Voodoo 5 5500. Dem Spiel sollte man aber eine potente CPU im "vierstelligen" Megahertz Bereich gönnen damit es auf ner Voodoo 5 flüssig bleibt.

NOLF1 hier auf einer 200MHz Voodoo 5 und 2GHz Athlon XP in 1280x1024x16 Auflösung ohne Kantenglättung. Qualität leider nicht so gut, weil wurde noch abgefilmt, dafür mit direkt eingespieltem Audio.

Also Operation Flashpoint (2001) hat mich damals visuell absolut begeistert umso größer war die Freude, das Glide unterstützt wurde. Somit lief das Spiel wirklich Prima auf einer Voodoo3.

Leider ist das Spiel schlecht gealtert.

Hier, habe ich vor über 5 Jahren hochgeladen (wie die Zeit vergeht). Mit 4 fach Full Scene-Anti-Aliasing (FSAA) sieht das Spiel schon auch heute noch sehr fein aus.

Läuft etwas grenzwertig in der 1024 Auflösung auf der V5 6000 mit 4x FSAA, aber noch im Toleranzbereich und ist ja auch kein High FPS Game wie Unreal Tournament.

bei weitem nicht ;}

Stimme wohl zu, etwas zu optimistisch, aber für einen 10er darf man da auch nix rum meckern. Die optimale Einrichtung wird natürlich seine Zeit in Anspruch nehmen, denn bei den normalen Retro PCs habe ich auch Tage/eher Wochen gebraucht, bis alles perfekt lief.

Naja Maxwell und Pascal machen weniger Probleme mit Veränderungen am BIOS. Turing war nicht möglich, aber ich habe schon lange nicht mehr nach gesehen.

Braucht auch nix mehr investiert werden, 4GB RAM und eine 250GB SSD verbaut. max. Ausbaustufe für ein 32-Bit Windows XP. Audio und Kopfhöranschluss an der Front auch vorhanden. Ein externes USB DVD Laufwerk ist auch vorhanden als Reserve. Somit kann die Spielerei mit dem Teil direkt beginnen. ![]()

Ich hätte die Möglichkeit ein Foxconn Thin Client Sys um einen 10er zu bekommen. Hier ist die verbaute Hardware, darauf läuft gerade Win 10 64-Bit.

Der Verkäufer hat das Sys immer als Arbeitsgerät benutzt, aber ist ihm mittlerweile zu langsam für YouTube und Co. Die iGPU ist eine Radeon HD 7340 mit 80 Shader und 523MHz Basistakt.

AMD E2-Series E2-1800 - EM1800GBB22GV

Ist dieses Teil hier: https://www.newegg.com/foxconn-nt-a3800/p/N82E16856119082

Da werde ich nicht lange überlegen für einen 10er...